Member-only story

Comment j’ai réduit de 93% le temps de génération de mon dataset d’images

En tant que data scientist, la préparation des données est très chronophage. Je dois régulièrement prétraiter de grosses quantités de données et je ne peux pas toujours prédire les erreurs que je vais rencontrer sur l’ensemble du dataset, il faut donc être méthodique.

- Commencer petit

Il peut y avoir des imprévus tout au long du process de préparation. C’est pourquoi il est préférable de commencer par un petit échantillon du vrai dataset à traiter (ici, comquelques images). Une fois que le processus est rodé, il faut effectuer une dernière exécution avec toutes les données et, en fonction de votre machine, cela peut prendre plusieurs heures, voire plusieurs jours (dans mon cas 8h qui sont devenues 30 minutes après application).

2. Faire chauffer le CPU

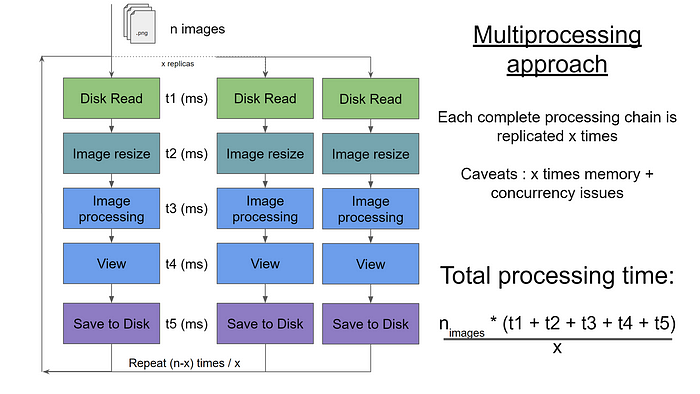

En général, lorsque vous avez beaucoup de données à traiter avec Python, vous devez rapidement recourir à la librairie de multiprocessing pour paralléliser les tâches, comme dans le graphique suivant.

C’est généralement le moyen le plus intensif en termes de CPU que vous puissiez utiliser avec Python, mais cela pose certains problèmes :

- Il n’est pas adapté lorsqu’il faut conserver l’ordre (pour traiter de la video ou du son par exemple)